적대적 공격의 기초 및 종류

1. 적대적 공격(Adversarial Attack)

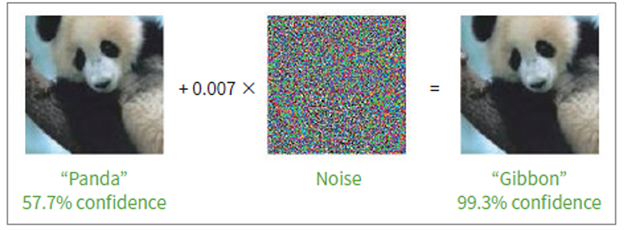

위 이미지는 2015년 ICRL에 출판된 'Explaining And Harnessing Adversarial Examples' 논문에서 소개된 대표적인 Adversarial Attack을 나타내는 그림이다.

위 예시를 설명하자면 x라는 input, 즉 정상적인 판다 이미지를 입력했을 때 57.7%의 확률로 판다라고 classification을 한다.

하지만, 여기에 0.007(ε) 만큼의 perturbation(일종의 noise)를 이미지에 더한다면 사람의 눈에는 알아차릴 수 없는(unnoticeable) 노이즈가 이미지에 포함되게 되고, 최종적으로 노이즈가 포함된 이미지에 대해 다시 classification을 진행했을 경우, 99.3%의 confidence를 가지고 gibbon(긴팔원숭이)라고 오분류(misclassify)를 하게 된다는 것이다.

따라서, 적대적 공격을 정리하면 다음과 같이 정의할 수 있다.

- 적대적 공격(adversarial attack): 머신러닝, 딥러닝 모델에 일종의 적대적 교란 혹은 노이즈(adversarial perturbation)을 적용하여 오분류를 발생시키는 공격

2. 적대적 공격의 종류

적대적 공격은 크게 회피 공격(evasion attacks), 중독(오염) 공격(poisoning attacks), 탐색적 공격(exploratory attacks)와 같이 3가지로 구분할 수 있다.

2.1. 회피 공격(evasion attacks)

먼저, 회피 공격은 위에서 언급한 적대적 예제(adversarial examples)를 사용하여 머신러닝 혹은 딥러닝 모델이 오분류 하도록 하는 공격으로, '입력 공격'으로도 불린다. 대표적인 예시가 바로 위에서 언급한 논문의 공격 기법인 FGSM(Fast Gradient Sign Method)이다.

2.2. 중독 공격(poisoning attacks)

다음으로, 중독 공격은 회피 공격과는 다르게 Attacker(공격자)가 머신러닝 혹은 딥러닝 모델의 학습 과정에 관여하여 AI 시스템 자체를 손상시키는 공격이다. 대표적인 중독 공격의 방법의 예시로는 2016년 MS(마이크로소프트)사의 챗봇 테이 사례가 있다.

이 사례는, 일부 극우 성향의 사용자들이 챗봇에게 악의적인 발언을 하도록 훈련시켜 테이가 욕설, 인종차별, 성차별, 자극적인 정치적 발언을 남발하도록 하여 16시간 만에 운영을 중단한 사례가 있다.

정리하면, 아래와 같이 악의적인 학습 데이터를 모델 학습 과정에 주입하여 모델을 망가뜨리는 공격하는 방법이다.

2.3. 탐색적 공격(exploratory attacks)

탐색적 공격의 대표적인 예로는 모델 전도 공격(Model Inversion Attack)과 API를 통한 모델 추출 공격(Model Extraction via APIs)가 있다.

- 모델 전도 공격: 모델 전도 공격은 모델에 수많은 쿼리를 던진 후, 산출된 결괏값을 분석하여 모델 학습을 위해 사용된 데이터를 추출하는 공격

- API를 통한 모델 추출 공격: 이미 공개된 API의 학습모델 정보를 추출하는 공격 기법

아래 그림은 전도 공격을 통해 얼굴인식 모델의 학습을 위해 사용된 얼굴 이미지 데이터를 복원한 사례이다.

모델 전도 공격은 공격 대상 모델의 입력값과 결괏값을 분석하여 학습 데이터를 추출하는 공격인 반면, 모델 추출 공격은 모델을 추출하는 공격이다. 즉, 유사한 모델을 만들어내는 공격 기법을 뜻한다.

References

[1] https://arxiv.org/pdf/1412.6572

[2] https://wikidocs.net/176802

2. Adversarial Attack

최근 보안시장에서는 새로운 멀웨어를 탐지하기 위해 AI가 활용되고 있습니다. 악성코드로 분류되는 확률을 최소화하도록 AI 모델을 공격하여 공격자는 악성코드 탐지 알고리즘…

wikidocs.net

[3] https://dl.acm.org/doi/10.1145/2810103.2813677

Model Inversion Attacks that Exploit Confidence Information and Basic Countermeasures | Proceedings of the 22nd ACM SIGSAC Confe

Publication History Published: 12 October 2015

dl.acm.org

[4] https://www.lgcns.com/blog/cns-tech/ai-data/9616/

머신러닝 보안 취약점! 적대적 공격의 4가지 유형 - LG CNS

미래학자인 레이 커즈와일(Ray Kurzweil)은 저서 ‘특이점이 온다(The Singularity is near)를 통해 오는 2045년이면 인공지능이 인간의 지능을 넘어설 것으로 예측했습니다. 세간을 충격에 빠뜨렸던 알파

www.lgcns.com

'Adversarial Attack' 카테고리의 다른 글

| 대한전자공학회 우수학생논문상 수상 (0) | 2024.12.05 |

|---|---|

| 딥페이크 범죄 예방이 가능할까? (2) | 2024.08.28 |