과대적합(overfitting) / 과소적합(underfitting)

학습 곡선(learning curve)

위와 같은 두 개의 그래프와 같이 훈련 세트의 크기와 오차를 나타낸 그래프를 학습 곡선(learning curve)이라고 한다.

각 그래프별로 첫 번째가 과소적합(underfitting), 두 번째가 과대적합(overfitting), 마지막이 과대적합과 과소적합 사이에서 절충점을 찾은 학습 곡선이다.

과대적합(overfitting)

위 학습 곡선은 전형적인 과대적합(overfitting)의 모습이다. 훈련 세트와 검증 세트에서 측정한 성능의 간격이 크다. 그래서 과대적합된 모델을 '분산이 크다(high variance)'라고도 말한다.

과대적합이 발생하는 주요 원인 중 하나는 훈련 세트에 다양한 패턴의 샘플이 충분하게 포함되지 않은 경우이다. 이런 경우에는 더 많은 훈련 샘플을 모아 검증 세트의 성능을 향상시킬 수 있다. 현실적인 한계로 인해 훈련 샘플을 추가적으로 모으기 힘들 경우에는 모델의 가중치를 제한하여 즉, 모델의 복잡도를 낮추는 방법이 있다.

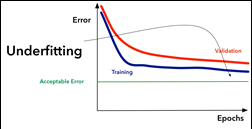

과소적합(underfitting)

위 학습 곡선은 전형적인 과소적합(underfitting)의 모습이다. 훈련 세트와 검증 세트에서 측정한 성능의 간격은 점점 가까워지지만 성능 자체가 낮은 경우로써 이렇게 과소적합된 모델을 '편향이 크다(high bias)'라고도 말한다.

과소적합은 모델이 충분히 복잡하지 않아 훈련 데이터에 이는 패턴을 모두 잡아내지 못하는 현상이다. 그래서 이를 해결하기 위한 대표적인 방법은 복잡도가 더 높은 모델을 사용하거나 가중치의 규제를 완화하는 것이다.

'AI & BigData' 카테고리의 다른 글

| [AI] 스테이블 디퓨전 AI 실사 모델 만들기 with Stable Diffusion WebUI (0) | 2023.07.27 |

|---|---|

| [AI] Diffusion: stable diffusion webui (0) | 2023.07.27 |

| [AI] 테스트 세트로 모델을 튜닝하면 안되는 이유 (0) | 2023.07.25 |

| [AI] 사이킷런을 활용해 훈련 세트와 테스트 세트로 나누기 (0) | 2023.06.22 |

| [AI] 로지스틱 손실 함수 - 크로스 엔트로피, 연쇄 법칙(Cross Entropy & Chain Rule) (3) | 2023.06.18 |